Если ваш степлер сам подкатил к ладони — не пугайтесь: это не полтергейст, а аккуратный UX на колесиках. В лабораториях Human-Computer Interaction Institute при Carnegie Mellon University придумали способ, как научить самые обычные вещи проявлять инициативу — вовремя подать, вежливо отъехать и деликатно подстраховать.

Идея звучит по-домашнему просто: пусть помощь будет там, где мы уже живем — на столе, на кухне, в офисе. Команда Александры Ион из Interactive Structures Lab и докторантки Виолет Хан делает «ненавязчивый» физический ИИ: предметы не ждут команд, они сами считывают контекст и действуют. Секрет в связке из потолочной камеры, компьютерного зрения, языковой модели и крошечных колесных платформ. Камера наблюдает, система переводит увиденное в текстовое описание, LLM рассуждает о целях человека, а затем передает предметам план «как помочь прямо сейчас».

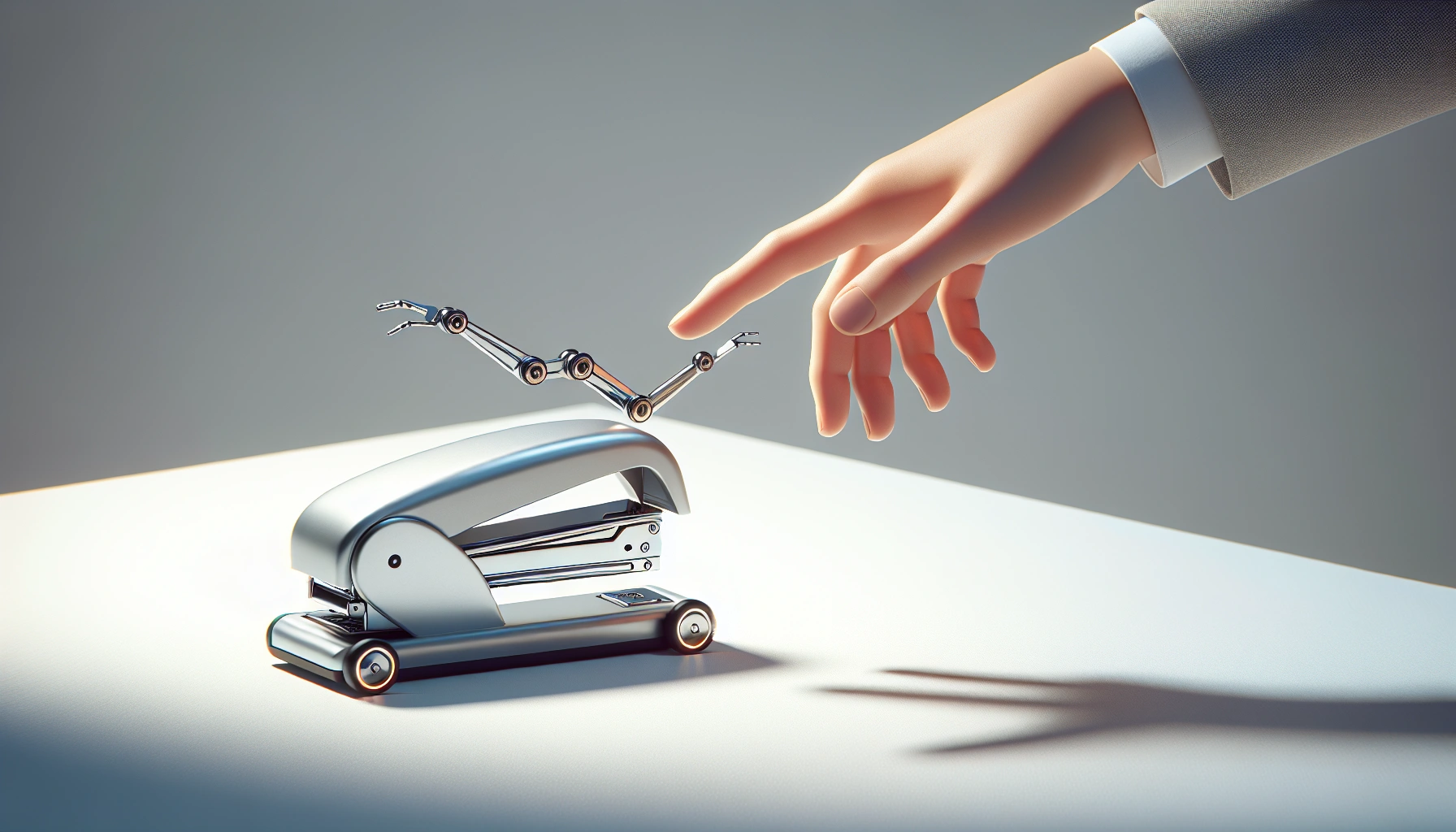

Отсюда — почти магические сцены. Степлер скользит навстречу руке в момент, когда вы ищете его взглядом. Нож чуть отползает, если кто-то опирается на столешницу. Кружка — не просто посуда, а тактичный напарник, который занимает правильное место на перегруженном столе. Важное слово — «ненавязчивость»: объекты не мельтешат, а деликатно вплетаются в рутину.

Исследователи смотрят шире, чем столешница. Представьте, вы входите с пакетом продуктов — и из стены расправляется складная полка, чтобы принять ношу, пока вы снимаете пальто. Тот же принцип может работать в домах, больницах, на производстве: безопасные, понятные и предсказуемые физические интерфейсы, которым доверяешь, потому что это… те же самые привычные вещи.

Работа команды Interactive Structures Lab уже отмечена сообществом: результаты приняты на 2025 ACM UIST в Пусане. Но главная интрига впереди — как сделать так, чтобы эта интеллигентная помощь оставалась почти «невидимой», а польза ощущалась каждую минуту. Если технологии и дальше будут такими тактичными, мы, возможно, впервые по-настоящему почувствуем, что «умный дом» — это не гаджеты, а заботливое пространство вокруг нас.