Если бы эпитопы умели разговаривать, они бы давно наняли переводчика — к счастью, его роль взял на себя трансформер. Да, звучит как шутка про нейросети и иммунитет, но в этот раз её проверили в пробирке.

Исследователи из UNC обыграли классическую схему «язык → язык»: вместо французского и японского — пептид+MHC и CDR3β TCR. Их рамка TCR‑TRANSLATE, а в ней флагман TCRT5 (вариант T5), учится «переводить» эпитоп в кандидатный TCR. Это не простая фантазия: на независимых эпитопах модель обошла публичные ER‑TRANSFORMER и GRATCR, чаще попадая в кластеры, где обитают реальные связующие рецепторы, и даже восстанавливала точные совпадения.

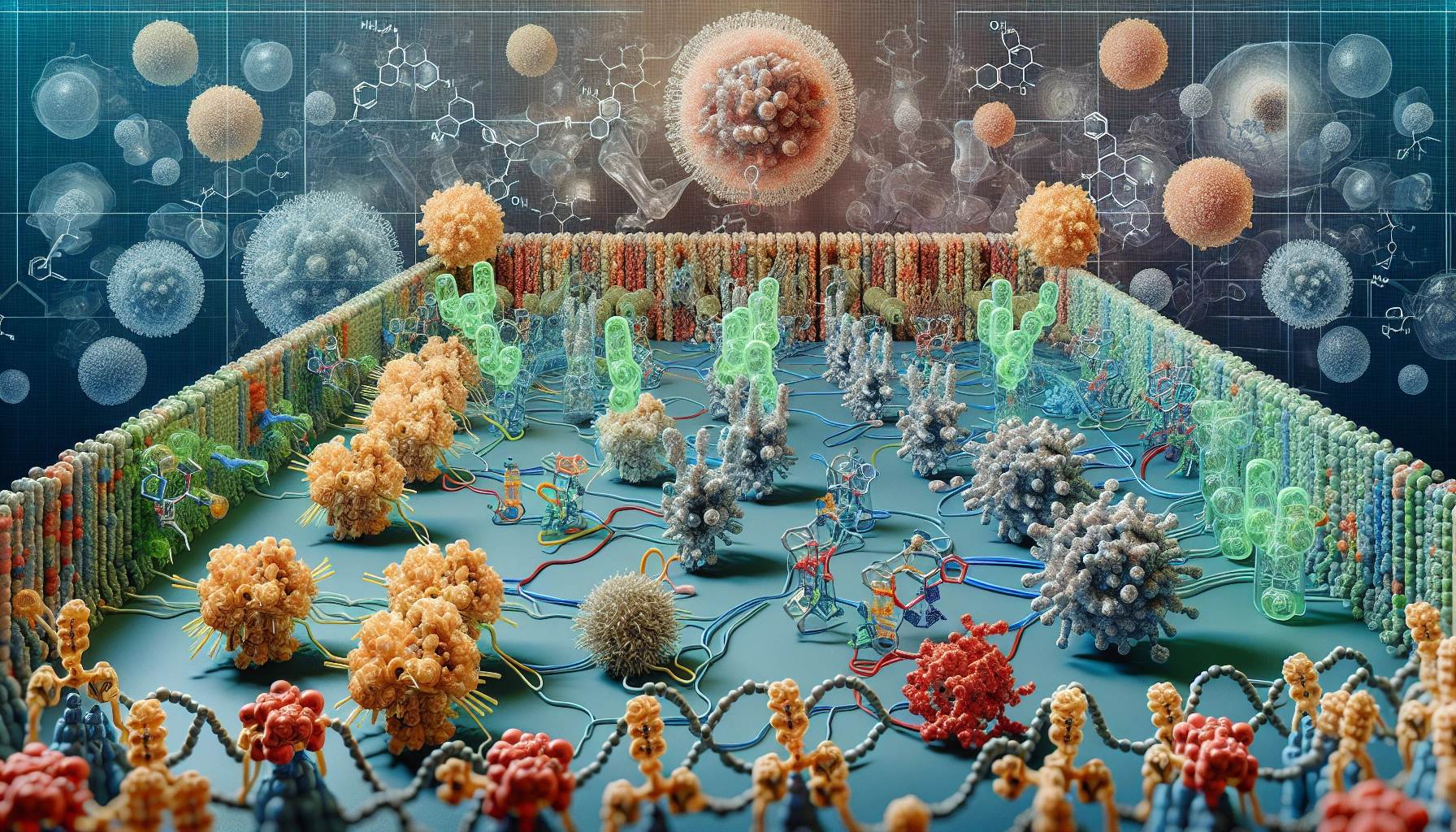

Но главная сцена — мокрая биология. Команда сгенерировала сорок CDR3β для сложного, не вирусного эпитопа WT1 (онкологическая мишень) и пересадила их в известную конструкцию TCR. Все сорок корректно экспрессировались на поверхности клеток — маленькая победа инженерии — и одна последовательность вызвала специфическую активацию в репортёрной системе. Да, активность уступала эталону, а ещё проявилась перекрёстная реактивность к «сборнику патогенов»: это честное зеркало природы TCR — полиспецфичность помогает иммунитету, но требует тонкой настройки для терапии.

Технические нюансы подмигивают знатокам NLP. Приёмы «низкоресурсного» перевода (двунаправленное обучение, мультитаск) повышают метрики, но сужают разнообразие: модели тянутся к «безопасным» высокогенерабельным мотивам. Beam search, как и в тексте, ищет «моду» — и получает хорошие F1, но упускает редкие, потенциально ценные варианты. Авторы это видят и честно обсуждают: метрики — не истина, а компас.

Что в сухом остатке? Быстрый генеративный «фильтр» для поиска TCR под редкие мишени. Уже сегодня он сокращает пространство вариантов, завтра — с лучшими данными по не‑вирусным эпитопам, α‑цепи и селекции — может стать базой для персонализированных T‑клеточных терапий. Перевод начат; осталось добавить контекст и интонации.